在信息论中,熵(entropy)用于表示是接收的每条消息中包含的信息的平均量,也可以理解成随机变量的不确定性(这里的想法是,比较不可能发生的事情,当它发生了,会提供更多的信息)1

特性

设X是一个有限状态的离散型随机变量,其概率分布为

P(X=xi)=pi,i=1,2,…,n

那么随机变量X的熵定义为

H(X)=−i=1∑n(pilogpi)

熵越大,那么随机变量的不确定性就越大

公式理解

改写一下:将负号移到对数里面

H(X)=i=1∑npilogpi1

现在pi1表示不确定性

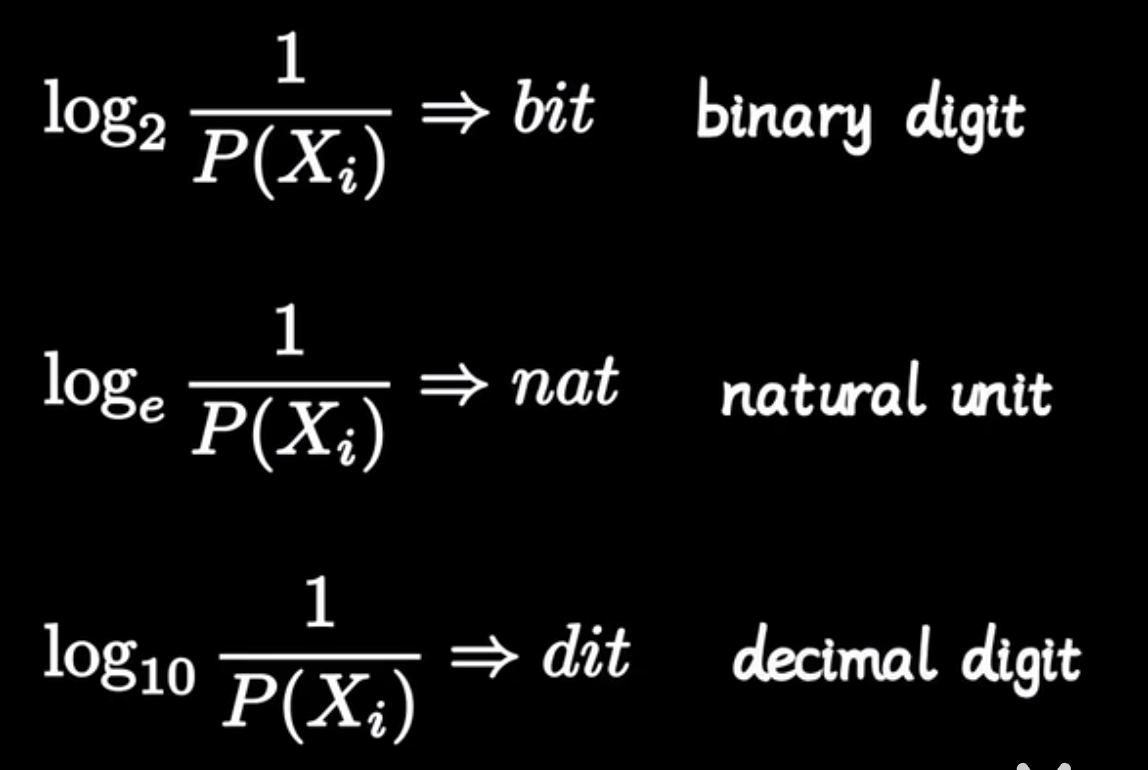

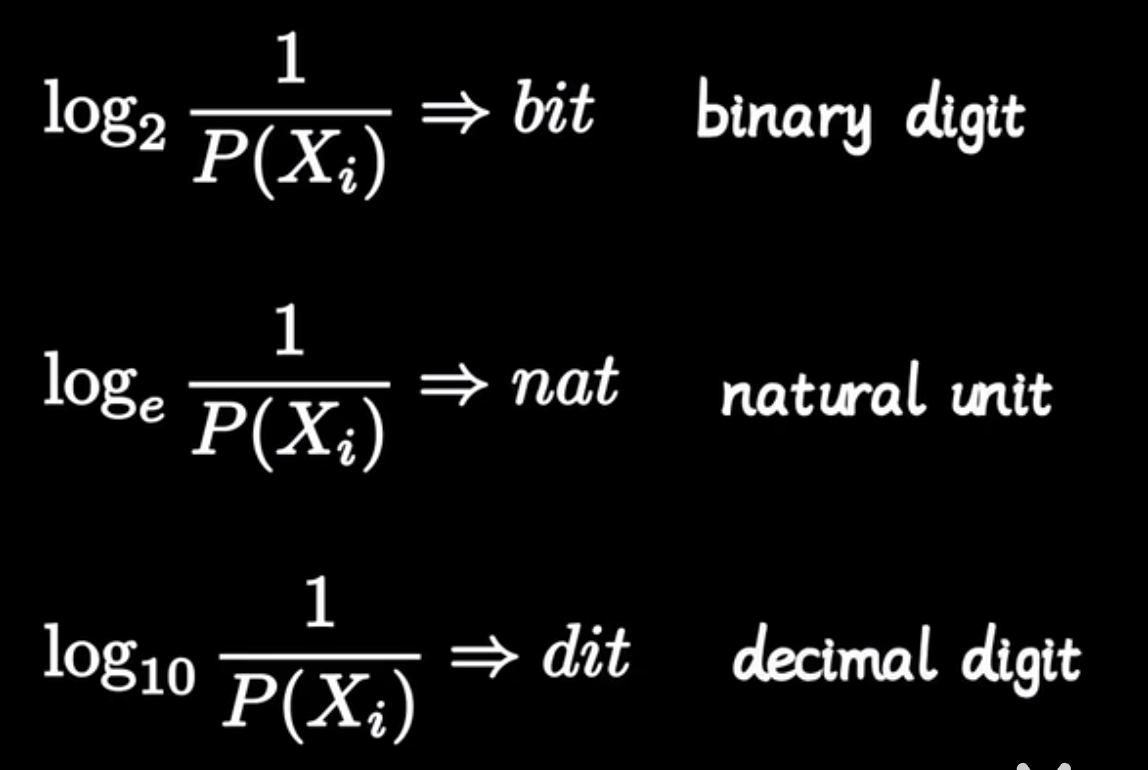

取logpi1表示这个不确定性需要的比特数字,也就是复杂程度。不同的底数表示不同的编码方式。

现在乘上pi表示加权,那么熵公式表示的是表示概率的平均复杂程度。

AI中各种熵的相互关系

信息熵

H(X)=−i∑np(xi)logp(xi)

联合熵

H(X,Y)=−x∑y∑p(x,y)logp(x,y)

条件熵

H(Y∣X)=−x∑y∑p(x,y)logp(y∣x)

互信息(信息增益)

I(X,Y)=x,y∑p(x,y)logp(x)p(y)p(x,y)

交叉熵

L(p,q)=−i∑p(xi)logq(xi)

相对熵(KL离散度)

DKL(p∥q)=i∑p(xi)logq(xi)p(xi)

Reference